超融合架構是通過軟件定義計算、存儲和網絡的方式,在一臺服務器設備中融合計算、存儲、網絡等資源,實現模塊化彈性資源擴展,形成統一資源池。相較于傳統IT基礎架構,超融合架構憑借其集成度高、部署快、運維便捷等優勢,成為越來越多的企業用戶推動數字化轉型的優先選擇。

超融合架構下的存儲服務以典型的分布式存儲架構為主,相比傳統的分離架構獨占物理硬件資源,超融合通過Linux Cgroup等技術,將存儲服務算力從系統中進行隔離使用,存儲服務以更加輕量化方式運行,性能參數更加匹配硬件資源。

存儲服務通常包括塊存儲、文件存儲和對象存儲服務,塊存儲和文件存儲服務對存儲性能、可靠性要求高,時延敏感,承載用戶部分關鍵業務,通常采用全閃存配置;對象存儲服務常用于備份、歸檔等業務,時延要求相對低,常采用SSD+HDD混合存儲方式部署。其中,塊存儲服務是超融合使用的主要場景。

為助力企業用戶構建超融合架構的現代化數據中心,滿足業務發展需求,憶聯聯合新華三在超融合架構下打造高性能存儲方案。

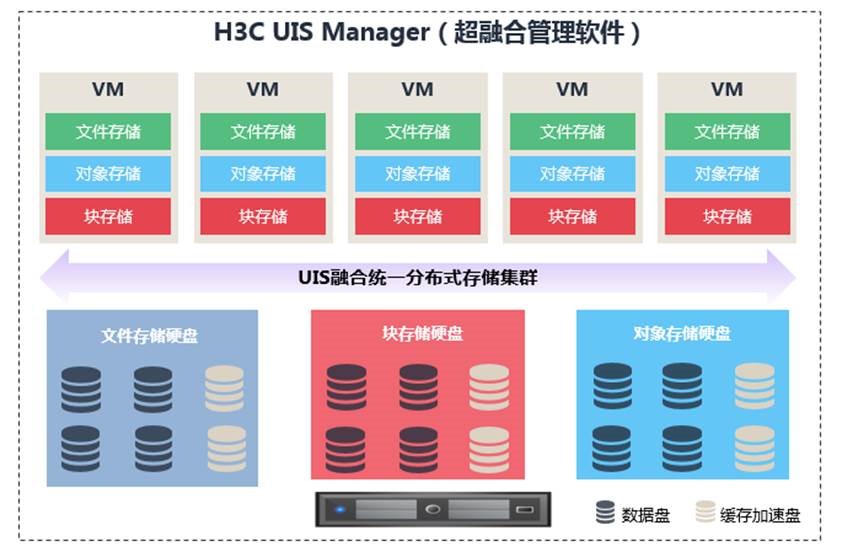

H3C UIS超融合管理平臺是新華三集團自主研發的面向下一代企業和行業數據中心的軟件定義基礎設施解決方案。在通用X86或ARM服務器上無縫集成計算虛擬化、存儲虛擬化、網絡虛擬化、安全虛擬化、數據庫服務、運維監控管理、容災備份、云業務流程交付等軟件技術。可自適應部署于私有云、混合云、邊緣云的全域云場景,為客戶提供極致融合、極優交付、極簡上云、極寬場景、極速性能的全無損云計算基礎架構,滿足數據中心未來十年信息化發展任意階段、任意規模、任意場景的技術架構變革需求。

圖1:H3C UIS超融合管理平臺架構圖

1 驗證環境

1.1 本次驗證硬件配置

|

類型 |

型號 |

硬件配置 |

|

服務器 |

2U2路服務器 |

CPU:Intel(R) Xeon(R) Gold 5318Y CPU @ 2.10GHz |

|

內存:12*16GB |

||

|

存儲控制器:支持RAID 1(系統盤) |

||

|

硬盤 |

系統盤 |

2*480GB SATA |

|

數據盤 |

4*3.84T NVMe SSD(憶聯UH711a) |

|

|

網卡 |

網卡 |

網卡:2*2端口10GE以太網卡 1*4端口千兆以太網卡 |

|

交換機 |

10GE交換機 |

48端口10GE交換機 |

|

注:實驗室使用3臺服務器,每臺分4塊數據盤,用戶可根據實際盤的數量需求進行配置(目前只支持512B扇區的NVMe盤) |

||

1.2 本次驗證軟件配置

|

類型 |

型號 |

版本 |

|

存儲軟件 |

H3C UIS超融合管理平臺 |

V7.0 (E0750P10) |

|

FIO |

IO測試 |

3.18 |

|

SAR |

網絡監控 |

10.1.5 |

|

IOSTAT |

盤側IO統計 |

10.0.0 |

|

MPSTAT |

CPU利用 |

10.1.5 |

1.3 本次驗證測試環境規劃

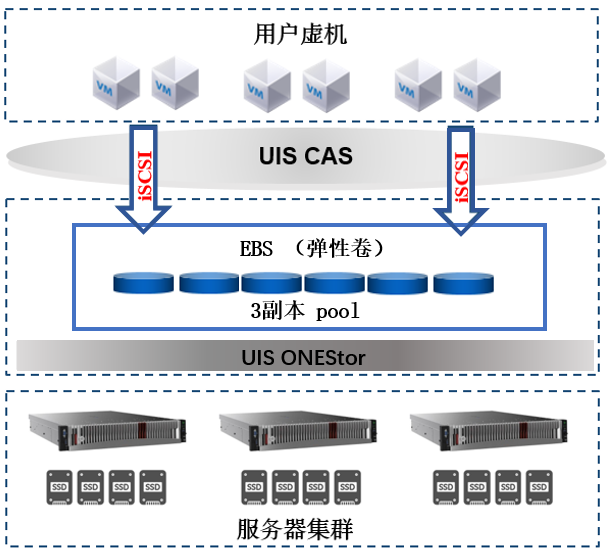

圖2:測試環境規劃架構圖

2 驗證方法

步驟1:塊存儲測試的存儲配置為存儲池采用3副本,配置6個虛擬機客戶端。在默認數據池(default Data Pool)創建6個大小為100GB的塊設備,并添加到iSCSI網絡存儲池中,虛擬機添加iSCSI網絡存儲池中的塊設備后進行IO測試。

步驟2:發IO測試前,需對服務端和客戶端的IO、CPU、網絡進行監控,每2秒采集一次數據,各對應如下命令:

# iostat -xmt 2 >> iostat.log &

# mpstat -P ALL 2 >> mpstat.log &

# sar -n DEV 2 >>sar.log &

步驟3:在各測試客戶端上運行fio任務后臺監聽服務,然后同時對6個塊設備下發IO(選取其中一個客戶端執行下發IO操作)。正式測試前需要對各塊設備進行預寫。fio參考命令如下:

# fio --server & //各客戶端開啟后臺監聽服務

# fio --client=host.list fio.job //各客戶端下發IO

步驟4:步驟3完成后,匯總所有客戶端fio的BW、IOPS、平均時延。

3 驗證結果

本次在H3C UIS塊存儲場景下的驗證結果如下:

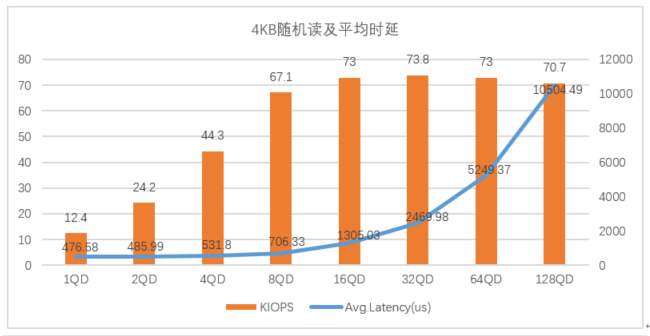

3.1憶聯UH711a在4KB隨機讀寫下的表現

圖3:憶聯UH711a在4K隨機讀寫下的表現

從圖3可以看出,在4KB隨機讀寫場景下,當隊列深度在1-32QD時,UH711a的IOPS呈增長趨勢,平均時延增長幅度較小,整體表現較好;當隊列深度大于32QD時,IOPS增長較少,平均時延增長幅度較大。

由此可見,在4KB隨機讀寫場景下,UH711a可為32QD及以下場景提供高性能、低時延的存儲服務。

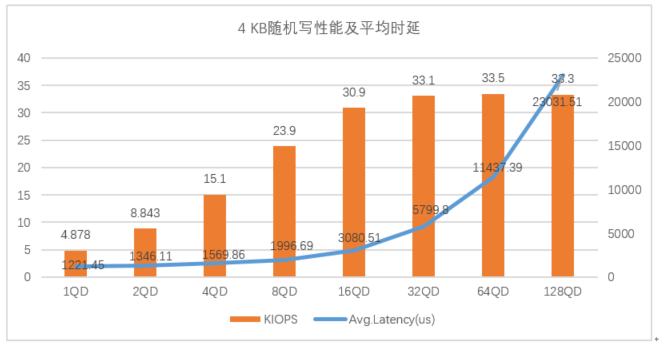

3.2憶聯UH711a在4 KB隨機7:3混合讀寫下的表現

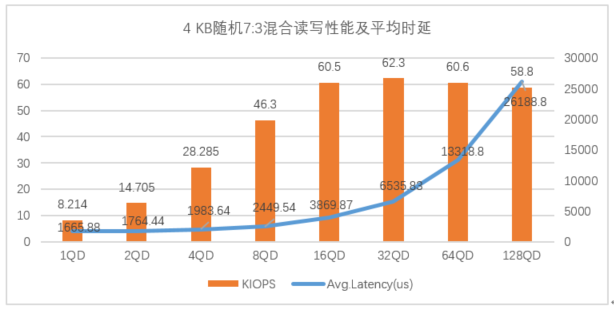

圖4:憶聯UH711a在4KB隨機7:3混合讀寫下的表現

如圖4所示,UH711a在4KB隨機7:3混合讀寫性能場景下,在32QD及以下展現優勢,IOPS峰值在32QD,可達62.3K,對應平均時延為6535.83 us(6.5ms )。當隊列深度大于32QD時,IOPS呈下降趨勢,平均時延顯著增加。

在此場景下,UH711a為32QD及以下場景提供最佳存儲性能。

3.3憶聯UH711a在128 KB順序讀寫下的表現

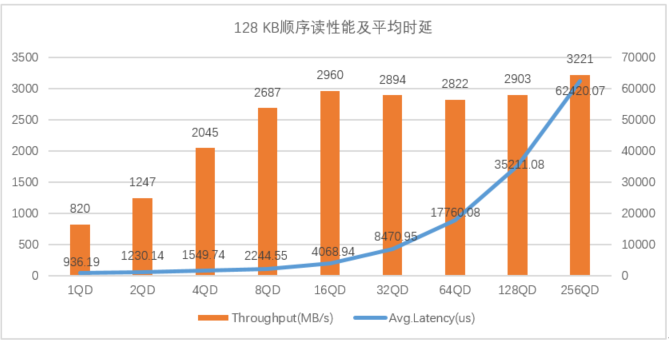

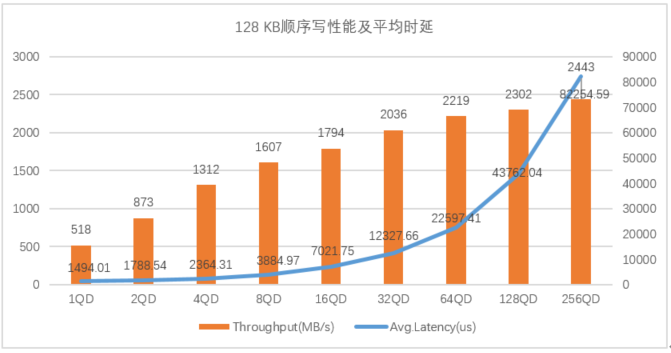

圖5:憶聯 UH711a 在128 KB順序讀寫下的表現

圖5展示了UH711a在128KB順序讀場景下,隊列深度在1到16QD時,UH711a讀帶寬呈線性增長趨勢,平均時延增長幅度較小;當隊列深度大于32QD時,讀帶寬下降,平均時延增長幅度較大。在128KB順序寫場景下,UH711a寫帶寬隨著隊列深度的增加而不斷提升,平均時延在1-32QD表現較好。

以上數據趨勢驗證了在128KB順序讀寫中32QD及以下場景UH711a的整體性能表現更為突出。

本次通過對4KB隨機讀寫、4 KB隨機7:3混合讀寫和128 KB順序讀寫等場景的實測,系統性地驗證了憶聯UH711a在H3C UIS場景下的極致性能和穩定發揮,尤其是在32QD及以下場景表現更優,能夠提供低時延、高性能的存儲服務,有效支撐超融合架構塊存儲業務對高性能固態硬盤的需求。

未來,憶聯將持續聯合H3C,基于 UIS超融合軟件平臺,為用戶提供成本更優、性能更優、運維更便捷的存儲解決方案。

地址:深圳市南山區記憶科技后海中心B座19樓

電話:0755-2681 3300

郵箱:support@unionmem.com