近年來,隨著云計算、5G、人工智能、物聯網、AI等新技術的快速發展和應用,數據量規模成指數級增長,傳統集中式存儲方案因可靠性、安全性無法保障,數據利用率低等弊端,無法滿足大規模的存儲應用需求,在此背景下分布式存儲應運而生。分布式存儲憑借其易擴展、高性能、成本優勢明顯、支持分級存儲、多副本一致性及存儲系統標準化等優勢成為云環境下存儲底座構建的重要選擇。

分布式存儲分為塊存儲、文件存儲和對象存儲,其中塊存儲主要是對計算集群虛擬機、容器提供彈性卷服務,而彈性卷EVS作為當前云業務平臺最核心的存儲服務,對存儲性能要求極高,在此基礎上各大云廠商基本采用全閃化形態部署。固態硬盤(SSD)以閃存為存儲介質,相比機械硬盤(HDD)具有讀寫速度快、延遲低、抗震性好等優勢,在分布式存儲中廣泛使用。

Ceph是當前業界應用最廣泛的開源分布式存儲軟件,具備高擴展性、高性能、高可靠等特點,同時支持塊存儲、文件存儲及對象存儲接口,已成熟應用于云計算的IAAS平臺。為更好助力分布式塊存儲系統性能及可靠性的提升,憶聯在Ceph平臺下開展實測。

Ceph是一個統一的分布式存儲系統,可提供較好性能、可靠性和可擴展性,是面向云計算領域重要的底層存儲系統,已在國內運營商、政府、金融、互聯網等多個行業落地應用。

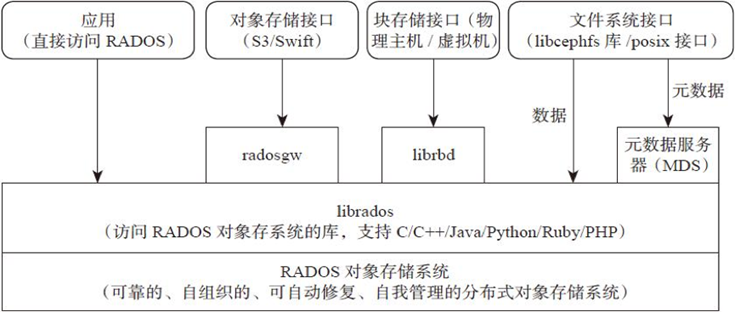

圖1:Ceph技術架構圖

Ceph主要分為應用接口層、存儲基礎接口層、存儲對象層,接口層主要負責客戶端訪問,分為本地語言綁定接口、塊存儲設備接口和文件系統接口,展現了Ceph統一性的特征。

在Ceph塊存儲系統中,數據以塊的形式存在卷里,塊為應用程序提供大存儲容量,可靠性和性能都更高,卷可映射到操作系統中,由文件系統層控制。Ceph塊存儲系統引入的RBD(Ceph塊設備)協議為客戶端提供了高可靠、高性能、分布式的塊存儲,同時RBD也支持其他的企業級特性,例如完整和增量式快照,精簡的配置,寫時復制( copy-on-write)式克隆,以及全內存式緩存等,從而大大提高了它的性能。

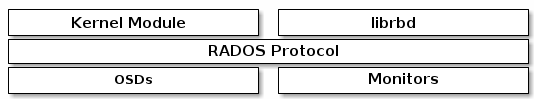

圖2:Ceph塊存儲組件

1. 驗證環境

1.1 本次驗證硬件配置

類型

型號

硬件配置

服務器

2U2路服務器

CPU:Intel Xeon Gold 6336Y @2.4GHz

內存:12*16GB

存儲控制器:支持RAID 1(系統盤)

網卡:2*2端口25GE以太網卡

硬盤

憶聯SSD

系統盤:2*480GB SATA

數據盤:8*7.68 NVMe SSD(UH811a)

交換機

25GE 交換機

48端口25GE交換機

1.2本次驗證軟件配置

|

類型 |

型號 |

版本 |

|

操作系統 |

CentOS(x86) |

7.6 |

|

存儲軟件 |

Ceph(開源) |

12.2.8 luminous |

|

FIO |

IO測試 |

3.7 |

|

SAR |

網絡監控 |

10.1.5 |

|

IOSTAT |

盤側IO統計 |

10.0.0 |

|

MPSTAT |

CPU利用 |

10.1.5 |

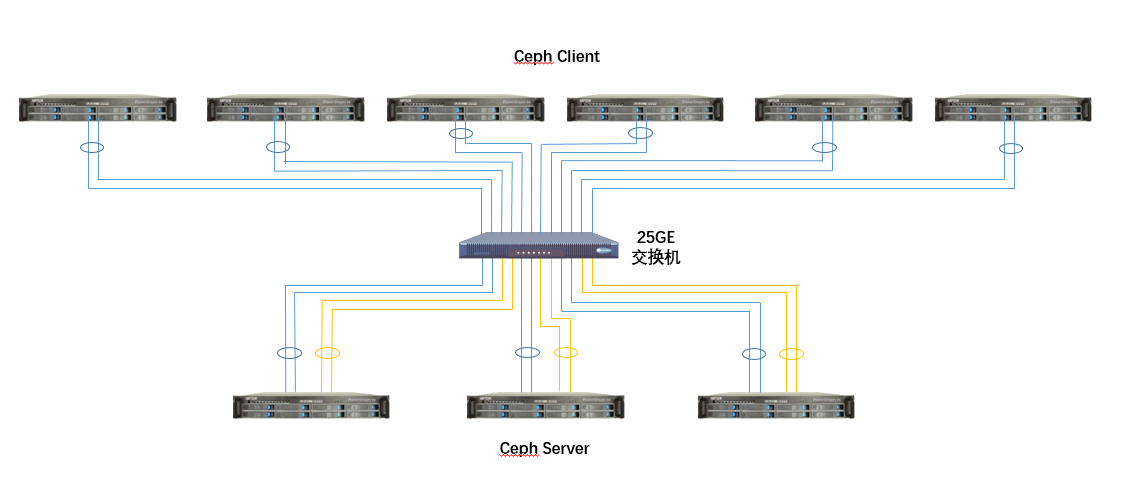

1.3本次驗組網規劃

圖3:Ceph組網規劃架構圖

步驟1:創建RBD pool和RBD卷。配置參數osd_pool_default_size確定RBD Pool池的副本數,2表示兩幅本,3表示三副本,根據實際副本數需求,將該配置項添加到ceph.conf中即可。另外根據規劃,需要創建60個大小為100GiB的RBD卷進行IO測試。

步驟2:下發IO測試前,需對服務器和客戶端的IO、CPU、網絡進行監控,每2秒采集一次數據。

步驟3:在6個客戶端上同時對60個RBD卷下發IO,每個客戶端均需綁核,即每個fio綁定不同cpu核。

步驟4:完成IO測試后,需關閉服務端和客戶端的IO、CPU、網絡進行監控。

步驟5:測試完成后,需匯總所有客戶端fio的BW、IOPS、平均時延,匯總對應的監控數據。對于BW和IOPS,累加各FIO對應結果即可;對于平均時延,累加之后需求平均值。

本次在 Ceph場景下驗證結果(以下結果為本次測試結果,僅供參考)如下:

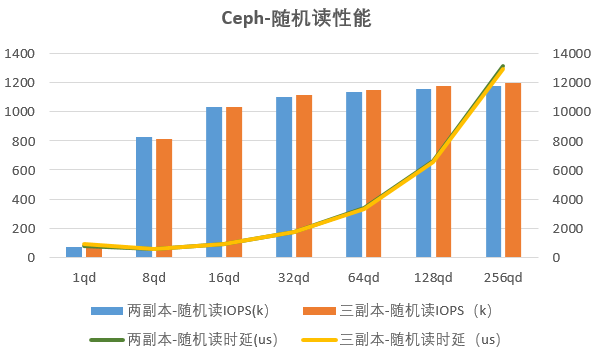

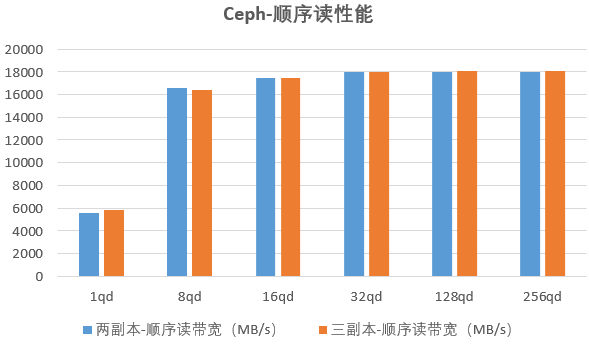

3.1憶聯UH8系SSD在隨機讀及順序讀下的表現

圖4:Ceph場景下憶聯UH8系SSD讀性能

從圖4可以看出,在Ceph分布式存儲系統下,不論是二副本還是三副本,憶聯UH8系SSD的讀性能基本持平。在時延方面,二副本與三副本趨勢基本一致,1QD至32QD間較為穩定,在32QD后時延明顯增加。

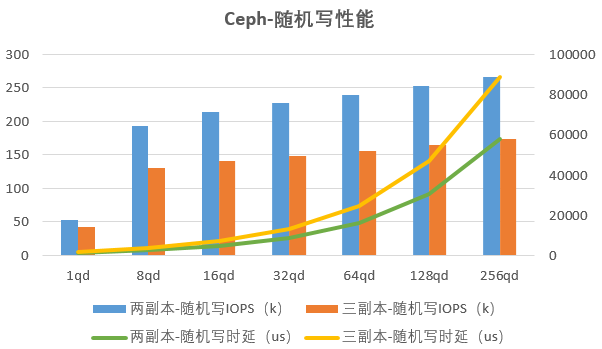

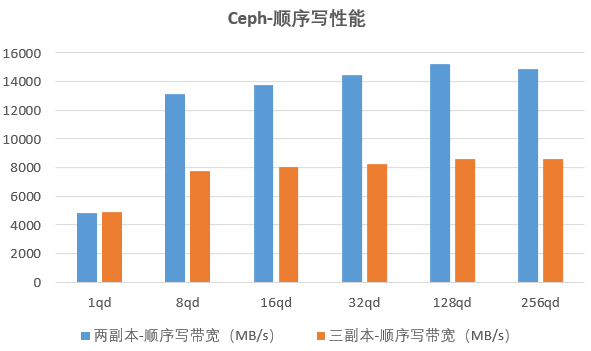

3.2憶聯UH8系SSD在隨機寫及順序寫下的表現

圖5:Ceph場景下憶聯UH8系SSD寫性能

如圖5所示,不論是在隨機寫還是在順序寫業務下,二副本寫性能遠高于三副本性能,主要是由于副本復制帶來的網絡及存儲開銷,造成三副本寫帶寬及寫IOPS下降明顯。在總體時延表現上,二副本明顯優于三副本。在時延變化趨勢上,二副本與三副本基本一致,皆在32QD后有比較顯著的上升。

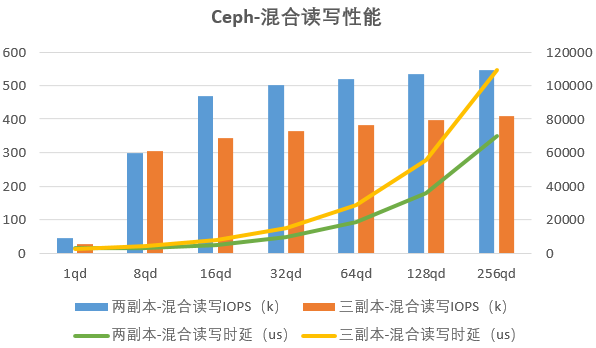

3.3憶聯UH8系SSD在混合讀寫場景下的表現

圖6:Ceph場景下憶聯UH8系SSD混合讀寫性能

從圖6可以看出,在4K 7:3混合讀寫業務場景下,從16QD起,二副本IOPS性能優于三副本。在時延整體表現上,二副本低于三副本,但在時延變化趨勢上,二副本與三副本基本一致,時延從32QD起,明顯上升。

結論:

從Ceph讀、寫、混合讀寫業務場景的實測數據中,可以看到憶聯SSD整體表現優秀,可為Ceph環境提供極致存儲性能。在時延上,憶聯SSD在32QD及以下場景中,表現亮眼,可獲得更佳的時延體驗。

3.4 智能多流降WA,有效提升SSD壽命

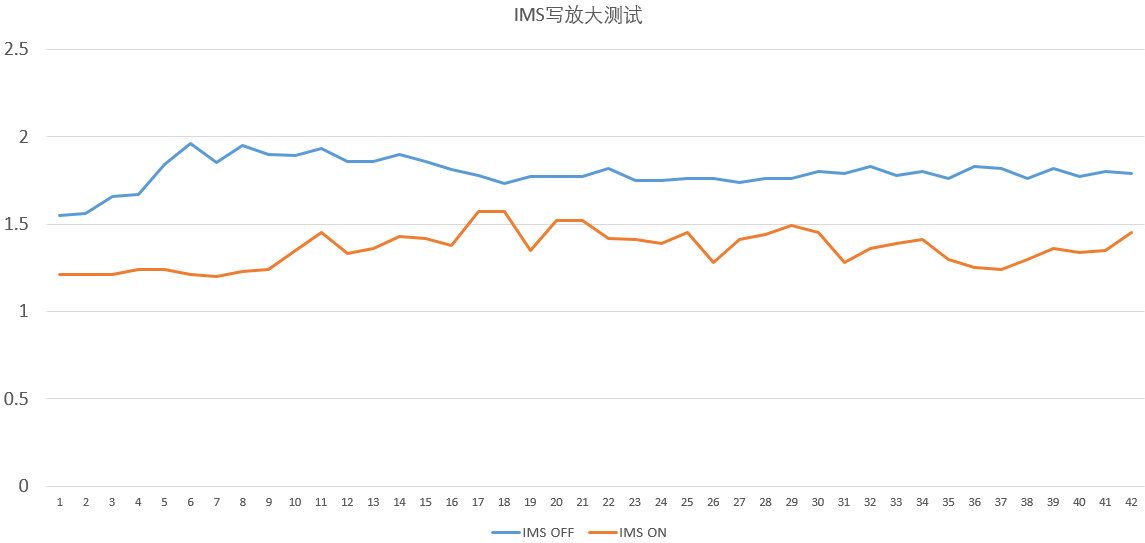

圖7: Ceph場景下智能多流特性測試

圖7: Ceph場景下智能多流特性測試

在Ceph方案中,基于標準JESD 219業務模型,針對SSD分別開啟、關閉智能多流進行寫放大測試,通過圖7對比驗證結果可以看到憶聯智能多流(IMS)開啟后,SSD寫放大降低20%+,極大提升了SSD壽命。

本次驗證清晰顯示了憶聯SSD 在Ceph分布式存儲系統下性能的穩定發揮,有效地支撐了Ceph的存儲需求,可提供始終如一的高性能,成為軟件定義存儲解決方案最優的選擇。同時,憶聯SSD獨有的智能多流技術可降低分布式存儲場景下SSD寫放大,提升SSD壽命,幫助用戶減少總體TCO。對于Ceph分布式存儲系統而言,憶聯SSD是一個可真正做到高性能、高可靠、低成本的存儲解決方案。

地址:深圳市南山區記憶科技后海中心B座19樓

電話:0755-2681 3300

郵箱:support@unionmem.com